Ооо нейромережеве🤖

У всьому винен штучний інтелект.

Посилання для друзів: https://t.me/+bXCkQ_uagrozYzVi

Навігація за хештегами: https://t.me/c/1591600888/2976

Монобаза: https://base.monobank.ua/EhJBDcb6zd52Ni

По рекламі: @neurokit Related channels | Similar channels

20 684

subscribers

Popular in the channel

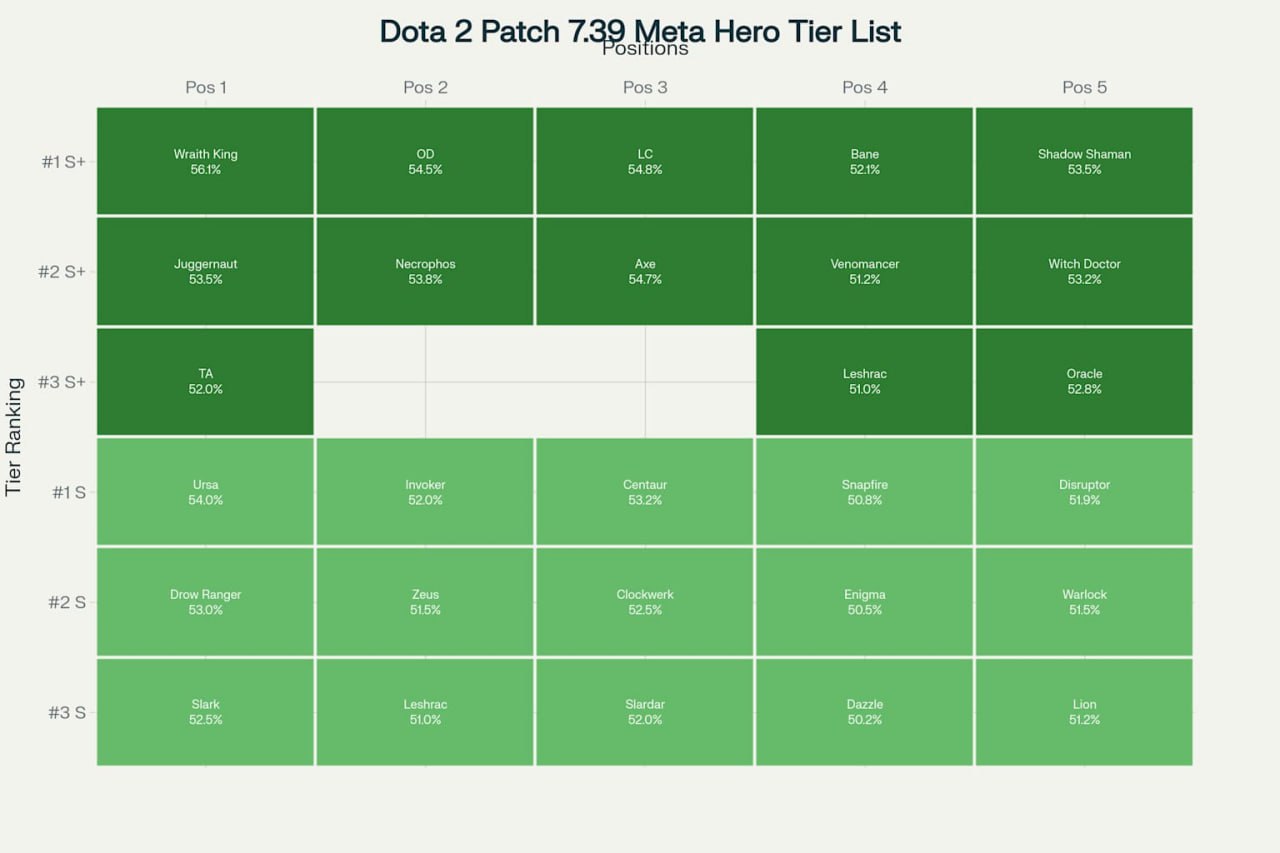

Провів класичний тест з Дотою: попросив зібрати ідеальну команду в актуальному патчі 7.39 ⌨️ Per...

Алхіміки тут? Вчені навчилися перетворювати свинець на золото в Адронному колайдері 🤬 Працює без...

Адміністрацію Трампа знову зловили на тому, що вони крінжово використовують ChatGPT 🤣 Міністр ох...

Є така прикольна ШІ-платформа n8n, яка дозволяє автоматизувати що завгодно: хоч публікацію дописі...

Ще трішки генерацій Veo 3, щелепа відпадає як від Sora рік тому 🤬 Я думаю, що Google в плані від...